Не встигли ми звикнути до термінів 4К і Ultra HD, дисплеям з квантовими точками і OLED, як виробники оголосили про прихід нової технології в сфері відео, яка неодмінно затьмарить всі попередні. Це HDR. Провідні світові видання вже напророкували їй блискуче майбутнє, оскільки вона, де, виведе якість зображення на недосяжний рівень для «старих» пристроїв. Але чи так це насправді? Давайте розбиратися!

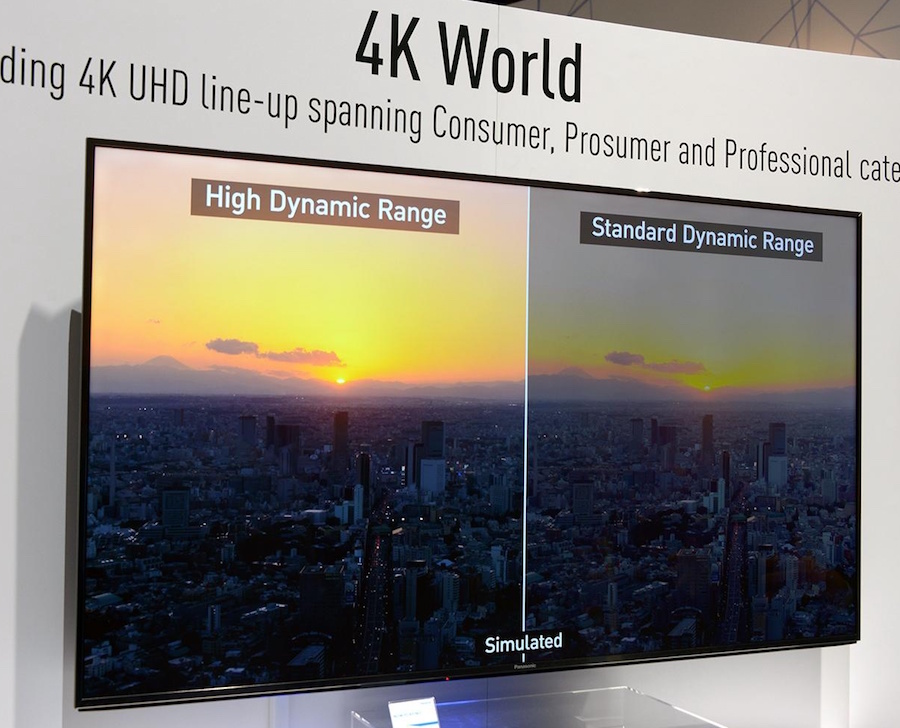

Перш за все, давайте розберемося з визначеннями. HDR - це High Dynamic Range, тобто широкий, а точніше розширений динамічний діапазон. Стосовно до зображення це виражається в більшому діапазоні яркостей між самими темними і найяскравішим півтонами. Зображення з реальним широким динамічним діапазоном виглядає контрастніше і «яскравіше» звичайного, в ньому більше деталей, а фарби виглядають більш насиченими. Проблема в тому, що таке зображення досить складно показати на більшості засобів відображення, будь то фотопапір, дисплей з електронними чорнилами, комп'ютерний монітор, телевізор або проекційний екран, тому що їх реальний динамічний діапазон не настільки великий, як хотілося б. Щоб створити фотографію з широким динамічним діапазоном зазвичай два або три знімки об'єднують в фоторедакторі начебто Lightroom або Photoshop так, щоб показати деталі, неминуче пропадає в тінях і на світлі в одному фото (в смартфонах весь процес відбувається автоматично). При грубому використанні налаштувань результат виходить дуже неприродним, тому мало кому подобається.

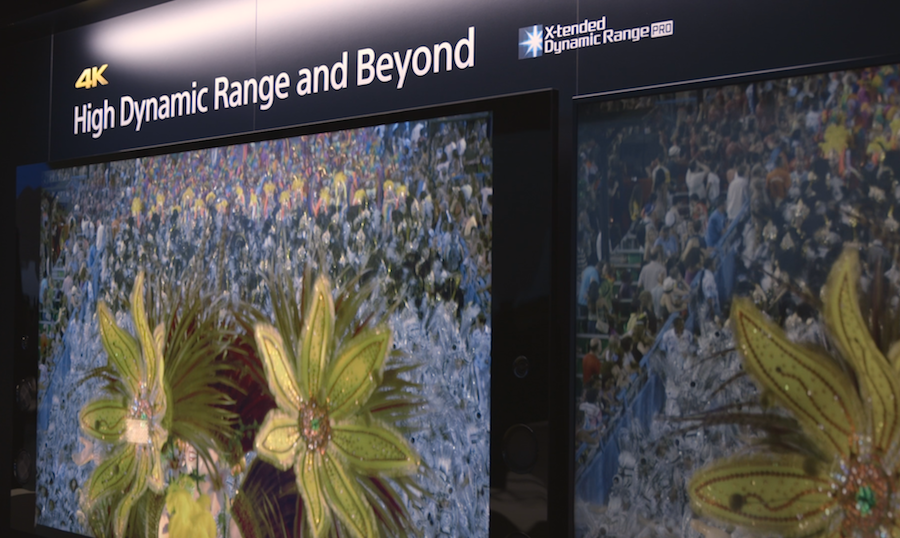

У відео два кадри ніхто не об'єднує - це неможливо, та й не потрібно нікому. Під високим динамічним діапазоном там розуміється зовсім інше, а саме збільшення візуальної контрастності зображення з поліпшення детальності, опрацювання в тінях, великою кількістю напівтонів на колірних переходах і т.д. Іншими словами HDR забезпечує візуальне поліпшення зображення практично за всіма параметрами, у чому на власні очі могли переконатися всі відвідувачі трьох останніх найбільших виставок в Берліні, Лас Вегасі і Амстердамі. Як це досягається? Це і є найцікавіше в даному питанні.

У рекламних матеріалах виробники навмисно дають з цього приводу дуже мало інформації, кажучи лише про те, що використовується відеосигнал з 10-бітовим кодуванням, який буде доступний на дисках в стандарті UHD Blu-ray і в трансляціях 4К-контенту через відеосервіси начебто Netflix, Amazon та ін. Крім того, особливо підкреслюється, що такий відеосигнал передається між пристроями тільки через роз'єми HDMI 2.0 c протоколом обміну інформацією HDCP версії 2.2. Цю дуже скупу інформацію радісно передрукували багато західних і деякі наші видання, назвавши «технологію HDR» революційної, адже в «звичайному» відео сигнал як відомо пишеться в 8-бітної формі. Це, мовляв, і забезпечує безпрецедентну якість зображення. Більш того, HDR нібито дозволить збільшити яскравість телевізорів в 2-2,5 рази - динамічний діапазон адже ширше!

HDR - це High Dynamic Range, тобто широкий, а точніше розширений динамічний діапазон. Стосовно до зображення це виражається в більшому діапазоні яркостей між самими темними і найяскравішим півтонами. Зображення з реальним широким динамічним діапазоном виглядає контрастніше і «яскравіше» звичайного, в ньому більше деталей, а фарби виглядають більш насиченими. Проблема в тому, що таке зображення досить складно показати на більшості засобів відображення, будь то фотопапір, дисплей з електронними чорнилами, комп'ютерний монітор, телевізор або проекційний екран, тому що їх реальний динамічний діапазон не настільки великий, як хотілося б.

Їх можна зрозуміти. Багато на власному досвіді переконалися, що збільшення "битности" сигналу в аудіо дає цілком об'єктивний приріст якості звучання, відчутний навіть при використанні кишенькових плеєрів в поєднанні з якісними внутрішньоканальні навушниками, не кажучи вже про дорогі стаціонарних системах. Однак в відео такий фокус неможливий, принаймні в доступному для огляду майбутньому. Відеосигнал для запису на диски і тим більше для трансляцій будь-якими засобами скорочується чистіше МР3 з реальним зменшенням дозволу за двома з трьох каналів кольоровості в 4 рази. Вам знайоме таке позначення «4: 2: 0», яке фігурує в описі властивостей відеосигналів всіх побутових носіїв і файлів HDTV і IPTV? Воно якраз і означає, що кольори в відео записуються з такими втратами. Кодування в 4: 2: 2 і 4: 4: 4 застосовується тільки на стадії мастерингу і в побуті не використовується взагалі.

Більш того, для ефективного стиснення 4К-відео без артефактів довелося навіть впроваджувати новий кодек Н.265, тому що застосовується в «звичайних» Blu-ray алгоритм H.264 дає шуми, які можна порівняти з розміром пікселя. Якщо ж відео реально кодувати в розрядністю 10 біт в кожному з трьох колірних каналів (RGB або Y-Cr-Cb), то бітрейт неминуче зросте в 4 рази, що для збереження на дисках і тим більше для трансляцій будь-якого роду неприйнятно.

Втім, для поліпшення якості зображення цього і не потрібно. Причин кілька. По-перше, ми, тобто наше зір, не в змозі розрізнити в чотири рази більше градацій яскравості в одному умовному кадрі одночасно. Ми не розрізняємо одночасно навіть 256 градацій, які забезпечує 8-бітове кодування відео - для цього нам потрібно або підвищувати, або знижувати загальну яскравість всього поля. Все багатство півтонів в природі ми розрізняємо завдяки рухомий райдужці - динамічної діафрагмі в наших очах, а так само адаптивної «налаштуванні» паличок (фоторецепторів) в сітківці. По-друге, в світі не існує жодного дисплея або іншого пристрою, який би забезпечувала передачу 1 024 градації яскравості одночасно, навіть прототипів немає. Та й не потрібні такі дисплеї по зазначеній вище причини.

Як же тоді забезпечити передачу відео з розширеним діапазоном наявними засобами? Так само, як це робилося раніше! Потрібно змінювати загальну яскравість на інших ділянках зображення. Тільки раніше всі пристрої це робили не надто коректно. Щоб візуально підвищити контрастність, а з нею і опрацювання півтонів тіней та світлих ділянках, телевізори міняли яскравість підсвічування (світіння осередків в плазмах), а проектори - діафрагму, беручи до уваги середню яскравість відеосигналу в кадрі, в результаті чого завжди виходив якесь компромісне зображення, мало схоже на реальність. Технологія HDR і покликана усунути цей компроміс.

Відеосигнал для запису на диски і тим більше для трансляцій будь-якими засобами скорочується чистіше МР3 з реальним зменшенням дозволу за двома з трьох каналів кольоровості в 4 рази. Вам знайоме таке позначення «4: 2: 0», яке фігурує в описі властивостей відеосигналів всіх побутових носіїв і файлів HDTV і IPTV? Воно якраз і означає, що кольори в відео записуються з такими втратами. Кодування в 4: 2: 2 і 4: 4: 4 застосовується тільки на стадії мастерингу і в побуті не використовується взагалі. Більш того, для ефективного стиснення 4К-відео без артефактів довелося навіть впроваджувати новий кодек Н.265, тому що застосовується в «звичайних» Blu-ray алгоритм H.264 дає шуми порівнянні з розміром пікселя. Якщо ж відео реально кодувати в розрядністю 10 біт в кожному з трьох колірних каналів (RGB або Y-Cr-Cb), то бітрейт неминуче зросте в 4 рази, що для збереження на дисках і тим більше для трансляцій будь-якого роду неприйнятно.

Протокол HDCP версії 2.2 дозволяє передавати додаткові метадані для зображення, в яких і буде закодована інформація про динамічно мінливої експозиції (яскравості) кадру і гамі (вважай контрастності). А телевізор або проектор в свою чергу, користуючись цими даними, можуть миттєво і, що головне, оптимально підстроювати зображення, як це відбувається в Photoshop. В результаті і виходить ідеальна картинка практично на будь-якому дисплеї або екрані. Візуально вона здається більш контрастною і яскравою, хоча в реальності ні гранична контрастність, ні яскравість дисплеїв не підвищується, тим більше в 2,5 рази до міфічних 1000 ніт, як пишуть деякі видання. Це просто неможливо. РК-дисплеї та монітори фактично досягли свого піку розвитку - підвищується тільки дозвіл, а контрастність і яскравість залишаються на рівні 10-річної давності. Розподілену підсвічування з світлодіодів, яка кардинально підвищує контрастність, застосовують дуже рідко через її високу ціну і бажання гранично зменшити товщину корпуса телевізорів. А значно підвищувати яскравість просто за рахунок потужних світлодіодів просто не можна через проблеми з охолодженням. Істотно збільшити яскравість OLED-дисплеїв теж не можна - вони будуть швидше деградувати, що неприйнятно. Та й не потрібно це зовсім. Тому що для отримання якісного зображення важливі не граничні характеристики, а тонка настройка. І ефектна поява HDR в відео це наочно показує.Юрій Глушков

Але чи так це насправді?

Як це досягається?

Вам знайоме таке позначення «4: 2: 0», яке фігурує в описі властивостей відеосигналів всіх побутових носіїв і файлів HDTV і IPTV?

Як же тоді забезпечити передачу відео з розширеним діапазоном наявними засобами?

Вам знайоме таке позначення «4: 2: 0», яке фігурує в описі властивостей відеосигналів всіх побутових носіїв і файлів HDTV і IPTV?